오늘 Build AI with Google에 참여했어요. 지난주 발표한 Google I/O에 이어 크게 5개의 섹션으로 나누어 설명해주었어요. 설명해준 내용에 대해 전반적으로 내용을 먼저 공유 드릴게요

1. Google Cloud – Build AI with Google AI Eco-system

첫 번째 섹션에서는 AI 생태계에 대한 설명이 이루어졌어요. 구글은 AI 혁신을 이끄는 다양한 도구와 기술을 제공하고 있으며, 그 중에서도 구글 Gemini와 함께 사용할 수 있는 여러 라이브러리와 그 업데이트 내용에 대해 다뤘어요.

구글의 AI 생태계는 여러 산업에서 활용되고 있으며, 기술 혁신과 비즈니스 성장을 동시에 이끌고 있어요. 구글은 다양한 분야의 기업들과 협력하여 AI 기술을 발전시키고, 이를 통해 실질적인 성과를 내고 있어요.

Google Cloud – Build AI with Google AI 기술의 다양한 산업 적용 사례

- 기술 & 혁신 (Technology & Innovation)

- AI 기반 모델, 챗봇, 지능형 어시스턴트 등 다양한 기술을 활용하여 혁신을 이루고 있어요.

- 대표적인 파트너: Anthropic, AppLovin, Cohere, Character.ai, LG AI Research

- 금융 서비스 (Financial Services)

- 사기 탐지, 리스크 평가, 고객 서비스 등 금융 분야에서도 AI의 활용이 확대되고 있어요.

- 대표적인 파트너: Goldman Sachs, Wells Fargo, BNY Mellon

- 소비재 & 리테일 (Consumer Goods & Retail)

- 고객 지원, 재고 관리, 가격 최적화 등에서 AI 기술을 활용하여 운영 효율성을 높이고 있어요.

- 대표적인 파트너: The Home Depot, Wendy’s, Walmart

- 제조 & 물류 (Manufacturing & Logistics)

- 예측 유지보수, 품질 관리, 공급망 관리 등 제조 및 물류 분야에서도 AI의 적용이 활발해요.

- 대표적인 파트너: Ford, GE Appliances, UPS, United States Steel

- 미디어 & 엔터테인먼트 (Media & Entertainment)

- 콘텐츠 생성, 개인화, 광고 최적화 등에서 AI가 큰 역할을 하고 있어요.

- 대표적인 파트너: MLB, Snapchat, Midjourney

- 임베디드 AI & 로보틱스 (Embedded AI & Robotics)

- 자율 주행, 안전 관리, 함대 관리 등에서 AI 기술을 활용하고 있어요.

- 대표적인 파트너: Cruise, Nuro

- 의료 & 헬스케어 (Medicine & Healthcare)

- 질병 진단, 신약 개발, 단백질 접힘 등 의료 분야에서 AI 기술이 혁신을 이끌고 있어요.

- 대표적인 파트너: AI2, Isomorphic Laboratories, Ordaos

AI 생태계의 발전과 미래

구글은 이러한 다양한 산업 분야에서의 성공 사례를 바탕으로 AI 생태계를 지속적으로 확장하고 있어요. 구글의 AI 기술은 기업들이 더 나은 서비스를 제공하고, 운영 효율성을 높이며, 새로운 비즈니스 기회를 창출하는 데 중요한 역할을 하고 있어요.

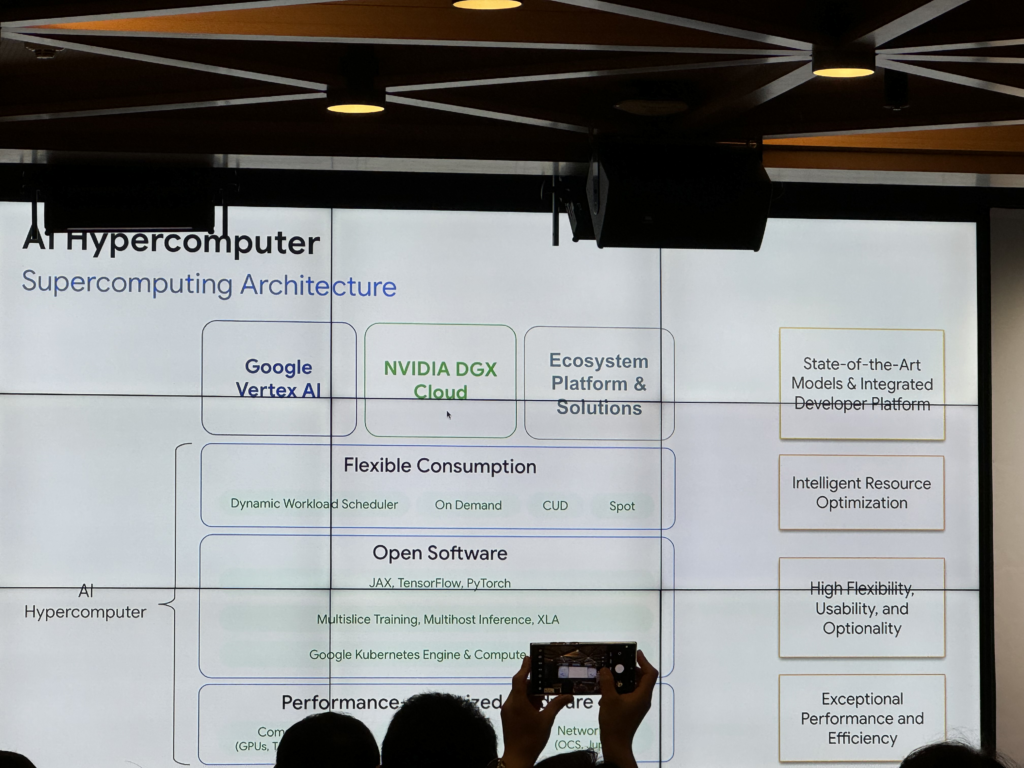

2. AI Hypercomputer

구글 클라우드는 AI 연산을 위한 강력한 인프라를 제공하고 있어요. 이번 섹션에서는 구글 클라우드의 AI 하이퍼컴퓨터와 관련된 다양한 기능과 장점에 대해 설명했어요.

Flexible Consumption (유연한 소비)

구글 클라우드는 필요에 따라 컴퓨팅 자원을 효율적으로 사용할 수 있는 다양한 요금제를 제공하고 있다는 소식을 전해주었어요. 이는 구글 클라우드가 유연한 소비 방식을 통해 사용자들이 비용을 절감하고, 필요한 만큼의 자원만을 사용할 수 있게 하여 효율성을 높인다는 것을 의미해요. 예를 들어, Dynamic Workload Scheduler를 통해 작업 부하에 맞게 자원을 동적으로 조절하거나, On Demand, CUD, Spot 등의 다양한 요금제를 통해 사용자들이 적합한 요금제를 선택할 수 있게 해줘요. 이는 구글 클라우드가 AI 연산에 대한 접근성을 높이고, 사용자들이 더욱 효율적으로 클라우드를 사용할 수 있도록 지원하는 중요한 요소에요.

Open Software (오픈 소프트웨어)

오픈 소스 소프트웨어를 적극 활용하여 AI 생태계를 확장하고 있다는 점도 강조되었어요. 구글 클라우드에서는 다양한 프레임워크를 사용할 수 있는데, JAX, TensorFlow, PyTorch와 같은 인기 있는 AI 프레임워크를 모두 지원해요. 이를 통해 개발자들은 자신이 익숙한 도구를 사용하여 AI 모델을 구축할 수 있으며, 구글 클라우드의 인프라를 통해 대규모 학습과 추론 작업을 수행할 수 있어요. 또한, Multislice Training, Multihost Inference, XLA와 같은 고급 기능을 통해 AI 모델의 성능을 더욱 최적화할 수 있어요. 이러한 오픈 소프트웨어 생태계는 개발자들이 더 나은 AI 솔루션을 개발하고, 혁신적인 프로젝트를 수행하는 데 큰 도움이 되어요.

Performance Optimized Model (성능 최적화 모델)

구글 클라우드는 성능이 최적화된 AI 모델을 제공하여 개발자들이 높은 효율성과 성능을 갖춘 AI 솔루션을 쉽게 구축할 수 있도록 지원하고 있다는 소식을 전해주었어요. 성능 최적화는 AI 모델의 학습과 추론 속도를 크게 향상시키며, 이를 통해 복잡한 작업도 빠르게 처리할 수 있어요. 구글 클라우드는 AI 모델의 성능을 극대화하기 위해 GPU, TPU 등의 고성능 하드웨어를 제공하고, 네트워크와 스토리지 시스템도 최적화하여 전체 시스템의 효율성을 높이고 있어요. 이를 통해 개발자들은 더 적은 자원으로 더 큰 성과를 낼 수 있으며, AI 프로젝트의 성공 가능성을 높일 수 있어요.

AI 생태계의 미래

구글 클라우드는 이러한 다양한 기능과 장점을 바탕으로 AI 생태계를 더욱 확장하고, 다양한 산업 분야에서의 AI 활용을 촉진하고 있어요. 구글 클라우드의 AI 하이퍼컴퓨터는 뛰어난 성능과 유연성을 제공하여, 사용자들이 필요한 자원을 효율적으로 사용할 수 있게 하고, 오픈 소프트웨어를 통해 더 나은 AI 솔루션을 개발할 수 있도록 지원해요. 앞으로도 구글 클라우드는 AI 기술의 발전과 확산을 통해 혁신적인 솔루션을 제공할 계획이에요.

3. GPU/TPU

구글은 최근 AI 연산을 위해 인프라를 한층 더 강화한 소식을 전해주었어요. 기존에 많이 알려진 GPU 외에도 구글에서는 TPU(Tensor Processing Unit)를 사용하고 있는데, 특히 최근 업그레이드된 TPU는 뛰어난 성능을 자랑하며 다양한 기업들이 직접 사용 후기를 통해 그 우수성을 입증했어요.

Trillium을 통한 AI 혁신의 다음 단계

10여 년 전, 구글은 기계 학습을 위한 최초의 특수 칩의 필요성을 인식하고 2013년에 세계 최초의 특수 목적 AI 가속기인 TPU v1을 개발하기 시작했어요. 2017년에는 첫 번째 Cloud TPU가 등장했으며, TPU 없이는 실시간 음성 검색, 사진 객체 인식, Gemini, Imagen, Gemma와 같은 최첨단 AI 모델은 물론, 대화형 언어 번역까지 가능하지 않았을 거예요. 실제로 TPU의 규모와 효율성 덕분에 구글 리서치팀은 최신 생성 AI 알고리즘인 Transformers를 개발할 수 있었어요.

Trillium 칩당 컴퓨팅 성능 4.7배 증가

새로운 TPU는 처음부터 신경망용으로 설계되었으며, AI 워크로드의 훈련 및 제공 시간을 개선하기 위해 지속적으로 발전해왔어요. 최신 버전인 Trillium은 TPU v5e에 비해 칩당 최대 4.7배의 컴퓨팅 성능을 자랑해요. 이는 MXU(행렬 곱셈 장치)의 크기 확장과 클럭 속도 증가를 통해 이루어졌어요. 또한 SparseCores는 TensorCores에서 무작위 및 세분화된 액세스를 전략적으로 오프로드하여 임베딩이 많은 워크로드를 가속화해요.

2X ICI 및 고대역폭 메모리(HBM) 용량 및 대역폭

Trillium은 HBM 용량과 대역폭을 두 배로 늘려 더 많은 가중치와 더 큰 키-값 캐시를 처리할 수 있는 능력을 갖추고 있어요. 차세대 HBM은 더 높은 메모리 대역폭, 향상된 전력 효율성, 유연한 채널 아키텍처를 구현하여 메모리 처리량을 높여요. 이를 통해 대규모 모델의 훈련 시간과 제공 대기 시간이 개선돼요. ICI 대역폭을 두 배로 늘리면 포드의 256개 칩과 맞춤형 광학 ICI 상호 연결과 클러스터의 수백 개의 포드로 확장할 수 있는 Google Jupiter 네트워킹의 전략적 조합을 통해 학습 및 추론 작업을 수만 개의 칩으로 확장할 수 있어요.

다양한 기업의 TPU 사용 후기

많은 기업들이 TPU를 미리 사용해본 결과, 그 성능과 효율성에 대한 긍정적인 평가를 내리고 있어요. 특히 TPU를 통해 AI 모델의 훈련 시간이 크게 단축되고, 더 복잡하고 큰 규모의 모델을 처리할 수 있어 혁신적인 AI 솔루션 개발이 가능해졌어요. 기업들은 TPU의 뛰어난 성능 덕분에 AI 프로젝트의 성과를 극대화할 수 있었으며, 이는 AI 기술 발전에 중요한 기여를 하고 있어요.

이와 같은 성능 향상 덕분에 구글은 TPU 사용을 적극 권장하며, AI 연산을 필요로 하는 다양한 산업 분야에서 TPU의 활용이 더욱 확대될 것으로 기대하고 있어요. TPU는 AI 혁신의 핵심 도구로서 앞으로 더 많은 분야에서 중요한 역할을 하게 될 거예요.

4. GKE

네 번째 섹션에서는 GKE(Google Kubernetes Engine)에 대해 다루었어요. GKE는 컨테이너화된 AI 배포를 용이하게 해주는 서비스로, 그중 가장 대표적이고 우리가 친숙한 Vertex AI와 새롭게 소개된 DWS Calendar Mode에 대한 소개 있었어요.

- Vertex AI: 머신러닝 모델의 통합 관리와 배포를 도와주는 플랫폼이며, 이를 통해 모델을 쉽게 학습시키고 배포할 수 있어요. 저도 많이 사용하고 있는 플랫폼이에요

- DWS Calendar Mode: 일정 기반의 자원 할당 기능으로, 특정 시간대나 날짜에 맞춰 자원을 효율적으로 사용할 수 있게 해줘요. 특히 다음과 같은 경우에 유용하다고 해요.

* Large Model Training: 대규모 모델 훈련 시 정해진 시간대에 자원을 집중 배치하여 효율적으로 훈련 할때

* Product Launches: 제품 출시 시점에 맞춰 필요한 자원을 미리 예약하여 안정적인 서비스 제공 할때

* Regular Fine-tuning: 정기적인 모델 파인튜닝 작업을 계획하여 자원을 최적화 할때

* Experiments & Tests: 실험 및 테스트 시점에 맞춰 자원을 예약하여 효율적인 자원 사용과 관리가 필요할때

5. Fine-Tuning vs RAG

Fine-Tuning과 RAG 는 TradeOff가 있어요. 과연 어떤 것이 좋을까? 어떻게 할루시네이션을 최소화할 수 있을까? RAG를 어떨때 사용하면 좋을까 등에 대한 고민을 구글도 열심히 하고 있구나 하는 것을 느낄 수 있었어요.

6. 기타

이번 세미나를 통해 구글 클라우드의 AI 기술과 인프라에 대한 깊은 이해를 얻을 수 있었고, 이를 통해 우리의 AI 프로젝트에 적용할 수 있는 다양한 인사이트를 얻을 수 있었어요. 앞으로 이 인사이트를 바탕으로 클리포에 적합한 멀티모달을 더욱 연구해볼 예정이에요.